En un contexto global donde la inteligencia artificial está transformando múltiples sectores, las instituciones de la Unión Europea (UE) y los gobiernos nacionales han comenzado a implementar una serie de normativas y directrices con el objetivo de asegurar un desarrollo ético, seguro y responsable de la IA (EU AI Act). Debemos conocer esta normativa por más pereza que nos pueda dar porque cualquier MVP que pretenda pasar a producción debe ceñirse a ella.

La IAR no se trata únicamente de desarrollar modelos tecnológicos avanzados, sino de priorizar el bienestar y los derechos fundamentales de las personas. Su enfoque gira en torno a principios como la justicia, la fiabilidad y la transparencia, promoviendo un equilibrio entre la innovación tecnológica y la protección de la privacidad y la seguridad. Este marco regulatorio busca garantizar que la IA se utilice de forma responsable, alineada con los valores éticos de nuestra sociedad, protegiendo tanto a los usuarios como al entorno en el que vivimos.

España, por su parte, busca consolidarse como un referente europeo en IA responsable. Vamos a detallar los principales marcos legales tanto a nivel europeo como nacional, así como los elementos clave que la componen.

Elementos de una IA Responsable

La Unión Europea ha establecido un conjunto de principios y medidas clave que cualquier sistema de IA debe cumplir para ser considerado “responsable”. Estos elementos aseguran que la IA funcione dentro de un marco ético, que respete los derechos humanos y que minimice los riesgos asociados a su uso. A continuación, se detallan los 7 elementos esenciales:

Sesgo en datos y modelos:

Al implementar técnicas de IA, las organizaciones deben establecer estándares, procesos de validación y controles de calidad de datos para minimizar errores y sesgos en los modelos de IA.

Transparencia y explicabilidad:

Los usuarios deben poder entender cómo los sistemas de IA toman decisiones, especialmente cuando esas decisiones impactan en la vida de las personas. Esto incluye proporcionar explicaciones y justificaciones para los resultados del sistema de IA y hacer que el proceso de toma de decisiones sea transparente e interpretable.

Privacidad y protección de datos:

El sistema de IA debe proteger la información privada y asegurar el cumplimiento de las leyes y regulaciones de privacidad, implementando medidas para salvaguardar los datos sensibles y previniendo el acceso o uso no autorizado.

Gobernanza y control:

Deben definirse claramente los roles y responsabilidades de los interesados involucrados en el desarrollo y despliegue del sistema de IA y asegurar que se prioricen las consideraciones éticas.

Alineamiento con los valores humanos:

Se trata de asegurar que los modelos de IA sean entrenados o ajustados en relación a los valores humanos, como por ejemplo evitar el odio, la toxicidad y la agresividad, y promover la honestidad, el respeto, la tolerancia, la justicia o la equidad.

Robustez y seguridad:

El sistema de IA debe probarse exhaustivamente, teniendo en cuenta posibles escenarios de fallo para minimizar riesgos y asegurando la seguridad del usuario.

Impacto social y ambiental:

Las tecnologías de IA necesitan mucha capacidad computacional, lo que puede resultar en un alto consumo de energía y un gran impacto en la huella de carbono. Por lo tanto, la IA responsable busca reducir este impacto ambiental mejorando la eficiencia energética de los sistemas de IA.

Gobernanza Holística de la IA

La gobernanza holística de la IA abarca todas las etapas del ciclo de vida de un sistema de IA, desde su concepción hasta su implementación y monitoreo continuo. Para garantizar la calidad y el cumplimiento normativo, se requiere una visión integral que coordine los esfuerzos entre distintos departamentos dentro de una organización, incluyendo los equipos de desarrollo de IA, legales y de cumplimiento.

Algunos puntos clave de la gobernanza incluyen:

Preparación:

Disponer del conjunto necesario de componentes para el cumplimiento y la gobernanza, además de desarrollar una visión clara de las medidas necesarias para cada caso de uso.

Cualificación:

Es esencial contar con personal cualificado. La falta de know-how es la mayor barrera para la transformación digital. Es crucial proporcionar formación para establecer un conocimiento común entre todos los participantes. Se recomienda crear workshops y mantener una comunicación directa entre departamentos, especialmente entre el desarrollo de IA y el área legal.

Evaluación del impacto de la regulación:

Identificar todos los proyectos de IA y su estado (planificado, en desarrollo, en activo), clasificarlos en base a los riesgos y evaluar el impacto del IA Act en cada caso de uso.

Valoración de posibles brechas legales:

Identificar posibles solapamientos o brechas legales entre distintas regulaciones aplicables, tanto anteriores como posteriores.

Estrategia de cumplimiento:

Diseñar una lista de medidas concretas para establecer la gobernanza de la IA y cerrar las brechas identificadas previamente, junto con los esfuerzos asociados y las prioridades correspondientes.

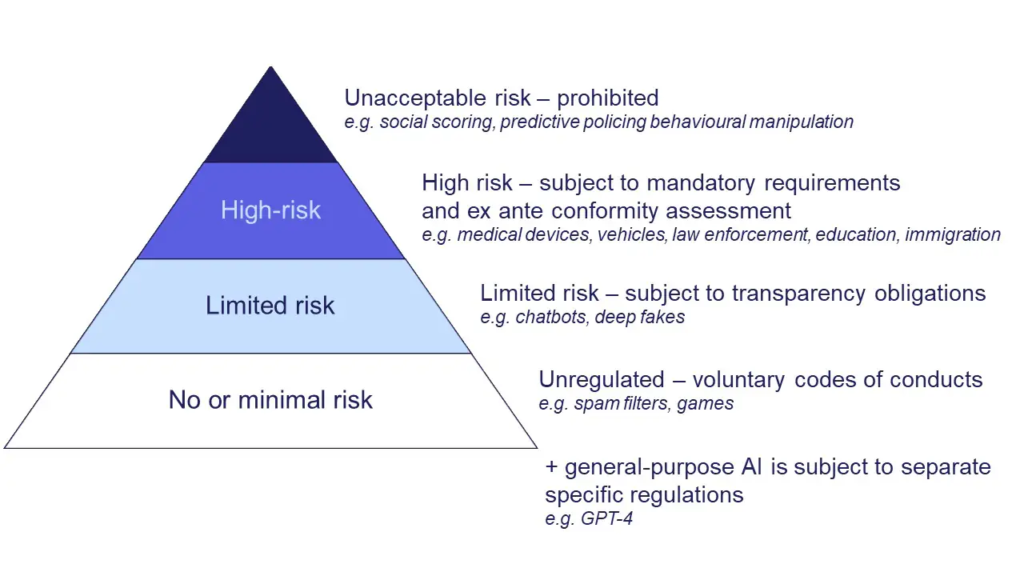

Clasificación de Riesgos de la EU AI Act

El enfoque del AI Act se basa en una clasificación de riesgos que determina el nivel de intervención y supervisión necesaria. Esta clasificación se divide en cuatro categorías:

Riesgo Inaceptable:

Se prohíbe cualquier sistema de IA que represente una amenaza evidente para la seguridad, los derechos o la dignidad humana. Entre estos se encuentran, por ejemplo, sistemas de vigilancia biométrica masiva en espacios públicos y la manipulación subliminal.

Riesgo Alto:

Los sistemas que pueden afectar significativamente la vida de los ciudadanos, como aquellos utilizados en sectores críticos (educación, sanidad, contratación laboral, justicia, etc.), deben cumplir con estrictos requisitos de transparencia, supervisión humana y gobernanza.

Riesgo Limitado:

Se refiere a aquellos sistemas que requieren menos supervisión, pero deben garantizar un uso transparente. Ejemplos incluyen chatbots o IA de interacción con el usuario, donde el usuario debe ser informado claramente de que está interactuando con una máquina.

Riesgo Mínimo:

Incluye la mayoría de las aplicaciones de IA (como videojuegos o filtros de correo no deseado), donde no se exige una regulación específica más allá de las normas generales de seguridad y protección de datos.

Legislación en la Unión Europea y España

La regulación de la inteligencia artificial en la UE sigue una trayectoria firme hacia la creación de un ecosistema regulatorio que proteja los derechos fundamentales, garantice la transparencia y gestione los riesgos inherentes al uso de la IA. A nivel español, esta normativa se adapta y aplica con un enfoque particular en el desarrollo de tecnologías éticas y responsables.

1. Real Decreto 817/2023 (España)

El Real Decreto 817/2023 establece el marco regulatorio para el desarrollo de IA responsable en España. Este decreto subraya el compromiso del país para alinearse con las normativas europeas en cuanto a IA y, al mismo tiempo, busca desarrollar su propio enfoque hacia la creación de un ecosistema seguro y confiable de inteligencia artificial.

2. ISO 23894: Gestión de Riesgos

La norma ISO 23894 es un estándar internacional que especifica los procesos y las medidas necesarias para gestionar los riesgos asociados al uso de la inteligencia artificial. A nivel de IA responsable, esta norma proporciona un enfoque estructurado para identificar, evaluar y mitigar los riesgos, asegurando que las aplicaciones de IA no generen daños a los usuarios, las empresas o la sociedad en general.

3. GDPR: Reglamento General de Protección de Datos

El Reglamento General de Protección de Datos (GDPR, por sus siglas en inglés) es una normativa europea que regula el tratamiento de datos personales. Dado que la IA depende en gran medida del acceso y procesamiento de grandes volúmenes de datos, el cumplimiento de este reglamento es fundamental. El GDPR garantiza que las soluciones de IA respeten la privacidad y la protección de los datos personales, un pilar esencial para la IA responsable.

4. EU AI Act (Marco Regulatorio de la IA)

La Ley de Inteligencia Artificial de la UE (EU AI Act), es el primer marco legal integral para el desarrollo, uso y comercialización de la IA en Europa. Aunque no es un reglamento aún, se espera que este acto defina las obligaciones y restricciones aplicables a las diferentes aplicaciones de IA, clasificándolas en función del nivel de riesgo que representen para la sociedad. Este esquema de riesgos es un elemento clave, dado que contempla sanciones más estrictas para los sistemas de IA considerados de “alto riesgo”.

5. EU Data Governance Act (Ley de Gobernanza de Datos)

La Ley de Gobernanza de Datos de la UE, que entró en vigor en septiembre de 2023, proporciona un marco para el intercambio voluntario de datos en toda Europa. Esta ley establece los “Data Spaces”, plataformas donde tanto empresas como ciudadanos pueden compartir datos de manera segura, fomentando el uso altruista de los datos para maximizar los beneficios sociales y económicos. Es un componente clave en la gestión de IA responsable, ya que refuerza la transparencia y la confianza en el uso de datos.

6. EU Data Act (Ley de Datos)

La Ley de Datos de la UE entrará en vigor el 11 de enero de 2024 y tiene como objetivo regular el acceso, intercambio y uso de datos en la Unión Europea. Esta ley busca garantizar que los usuarios tengan acceso justo a los datos generados por los dispositivos que utilizan, promoviendo un modelo de datos equitativo, en beneficio tanto de las empresas como de los consumidores. La EU Data Act tiene implicaciones significativas para la IA, especialmente en el tratamiento de grandes volúmenes de datos que son esenciales para entrenar modelos de IA eficaces y responsables.

Cierre

El marco regulatorio actual en la Unión Europea y en España refleja una creciente preocupación por los riesgos asociados a la inteligencia artificial, así como el compromiso de estas instituciones para garantizar su desarrollo responsable. Las leyes como el EU AI Act y la EU Data Act son pasos importantes hacia la creación de un entorno donde la innovación tecnológica pueda prosperar sin comprometer los derechos fundamentales.

Por su parte, las empresas que deseen implementar soluciones de IA deben asegurarse de cumplir con estas normativas y seguir las mejores prácticas en términos de gobernanza, evaluación de riesgos y protección de datos para operar en un marco ético y legal y para no gastar en desarrollos que luego no puedan implementarse o al que haya que hacer cambios que podrían haberse evitado.

Espero que este artículo te sirva para tener una introducción a estos marcos regulatorios de la IA, ten en cuenta que cambian todo el tiempo y por lo tanto puede que algunos de estos aquí se hayan desactualizado o modificado. Lo ideal es que hables con un especialista en legales de IA que pueda asesorarte.